本篇讲述zookeeper单机及集群部署,笔者觉得还是比较详细,希望能帮助到急需补充该方面知识的朋友,如发现有问题请及时指出

导读

ZooKeeper是一个分布式的,开放源码的分布式应用程序协调服务,是Google的Chubby一个开源的实现,是Hadoop和Hbase的重要组件。它是一个为分布式应用提供一致性服务的软件,提供的功能包括:配置维护、域名服务、分布式同步、组服务等。

ZooKeeper的基本运转流程:

1、选举Leader。

2、同步数据。

3、选举Leader过程中算法有很多,但要达到的选举标准是一致的。

4、Leader要具有最高的执行ID,类似root权限。

5、集群中大多数的机器得到响应并follow选出的Leader。

目前阿里开源的dubbo分布式服务框架推荐的注册中心。

其更详细原理可以参考:http://cailin.iteye.com/blog/2014486/

安装

接下来我们进入zookeeper的安装环节,zookeeper的安装总的来说比较简单,这里我准备了3台linux虚拟机,模拟集群环境,有条件的同学可以自己装3台(最少),其实集群和单机的区别不是太大,但是集群时节点数量一定是奇数(2n+1如3,5,7),可参考选举机制(FastLeaderElection算法)。

工具: CentOS.7,zookeeper-3.4.6,Xshell5

注:zookeeper本身由java编写,运行在java环境,故同学们必须先装好java环境,才可以继续zookeeper的安装,这里我对java环境不做讲解

单机模式

服务器CentOS7_64_1的ip:192.168.2.101

安装包下载

首先使用grid用户登录CentOS7_64_1,将zookeeper-3.4.6的安装包下载传至/home/grid目录下

http下载路径: http://apache.fayea.com/zookeeper/

linux命令下载:$ wget http://apache.fayea.com/zookeeper/zookeeper-3.4.6/zookeeper-3.4.6.tar.gz

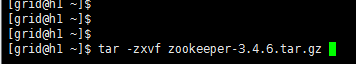

解压安装包

输入tar -zxvf zookeeper-3.4.6.tar.gz将其解压,如下:

创建data和logs目录

解压后进入zookeeper-3.4.6目录,创建data目录和logs目录,zookeeper默认是不带这两个目录的,需要用户自行创建并指定。

[grid@h1 zookeeper-3.4.6]$ mkdir data

[grid@h1 zookeeper-3.4.6]$ mkdir logs

创建myid文件

在/home/grid/zookeeper-3.4.6/data下创建myid文件

编辑myid文件,并在对应的IP的机器上输入对应的编号。如在第一台zookeeper上,我们给该myid文件内容指定就是1。如果只在单点上进行安装配置,那么只有一个server,后面讲集群的时候会有多台服务器时就会有2,3,4,5...等等。

[grid@h1 data]$ vi myid

1

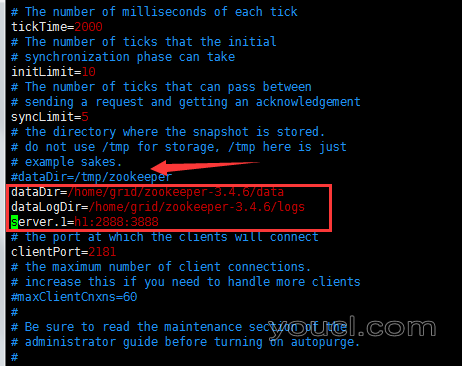

复制修改配置文件

接着进入zookeeper-3.4.6/conf目录下,将zoo_sample.cfg文件复制一份取名zoo.cfg

[grid@h1 conf]\$ cp zoo_sample.cfg zoo.cfg

注:之所以取名zoo.cfg是因为这是启动时默认约定读取的

server.1=h1:2888:3888的解释如下:

1是指一个数字,与前面创建的myid对应即可,标志这是第几台机器,h1是我配置的映射名,大家可以直接将h1改为自己的ip,如

server.1=192.168.2.101:2888:3888;

Hosts映射配置:vi /etc/hosts,输入自己的ip对应写个名字即可,与windows类似,此配置步骤可以忽略,直接在zookeeper下的zoo.cfg文件写ip地址即可

2888 表示的是这个服务器与集群中的 Leader 服务器交换信息的端,2888端口简单来说就是zookeeper服务之间的通信端口;

3888端口是zookeeper与其他应用程序通信的端口

其他cfg参数说明

-

tickTime

tickTime这个时间是作为Zookeeper服务器之间或客户端与服务器之间维持心跳的时间间隔,也就是每个tickTime时间就会发送一个心跳。 -

initLimit=10

initLimit这个配置项是用来配置Zookeeper接受客户端(这里所说的客户端不是用户连接Zookeeper服务器的客户端,而是Zookeeper服务器集群中连接到Leader的Follower 服务器)初始化连接时最长能忍受多少个心跳时间间隔数。当已经超过10个心跳的时间(也就是tickTime)长度后Zookeeper 服务器还没有收到客户端的返回信息,那么表明这个客户端连接失败。总的时间长度就是10*2000=20 秒。 -

syncLimit=5

syncLimit这个配置项标识Leader与Follower之间发送消息,请求和应答时间长度,最长不能超过多少个tickTime的时间长度,总的时间长度就是5*2000=10秒。 -

dataDir

dataDir顾名思义就是Zookeeper保存数据的目录,默认情况下Zookeeper将写数据的日志文件也保存在这个目录里。 -

clientPort=2181

clientPort这个端口就是客户端(应用程序)连接Zookeeper服务器的端口,Zookeeper会监听这个端口接受客户端的访问请求

增加环境变量

修改该用户下的.bash_profile文件,此文件默认为隐藏的

[grid@h1 data]$ vi /home/grid/.bash_profile

增加内容如下:

export ZOOKEEPER_HOME=/home/grid/zookeeper-3.4.6

export PATH=$ZOOKEEPER_HOME/bin:$PATH

使配置文件生效:

[grid@h1 data]$ source /home/grid/.bash_profile

防火墙配置

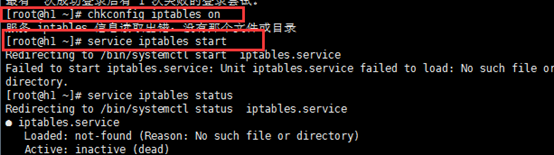

在防火墙中打开要用到的端口,一般默认是开放了22端口,所以我们才能使用远程工具使用22进行连接,现在我们去配置2181 2888 3888端口,切换到root用户执行如下命令

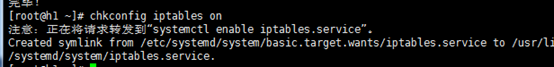

chkconfig iptables on 设置开机启动

service iptables start 启动防火墙

我这里设置时就报错了,报错咱就得解决

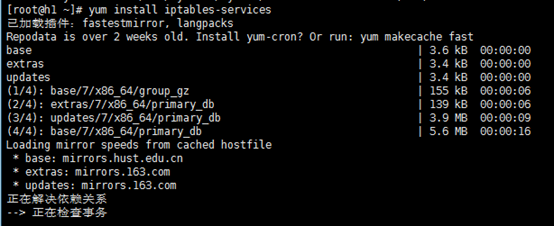

解决方案:执行下面命令下载安装插件

[root@h1 ~]# yum install iptables-services

安装完成后再次执行chkconfig iptables on,service iptables start命令

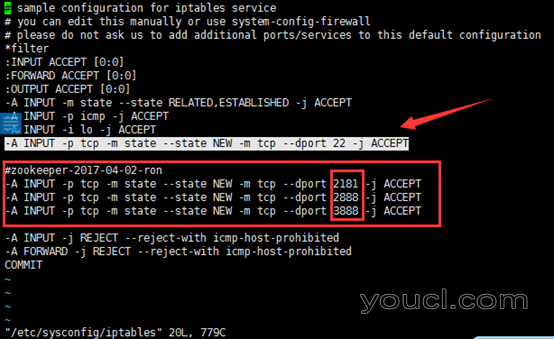

接下来继续开放防火墙端口

[root@h1 ~]# vi /etc/sysconfig/iptables

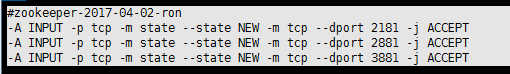

复制22端口那一行3次,然后将端口修改为需要开放的3个,如下:

重启防火墙

[root@h1 ~]# service iptables restart

开启zookeeper服务

启动并测试zookeeper(使用grid用户启动,不要使用root账户),在zookeeper目录的bin下面执行

[grid@h1 bin]$ ./zkServer.sh start

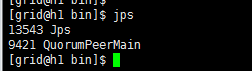

执行jps查看状态,其中QuorumPeerMain是zookeeper进程,启动正常

查看zookeeper服务输出信息,其日志信息文件在

/home/grid/zookeeper-3.4.6/bin/zookeeper.out下

[grid@h1 bin]$ tail -222f zookeeper.out查看日志命令

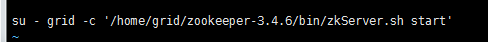

设置服务为开机启动

配置zookeeper为grid用户开机启动,不然在生产环境会很麻烦

编辑/etc/rc.local文件,加入:

vi /etc/rc.local

su - grid -c '/home/grid/zookeeper-3.4.6/bin/zkServer.sh start'

注:su – grid是指切换到grid用户,-c是指调用后面命令

好了,单机版就讲到这里,下面我们讲解集群的配置

集群模式

服务器CentOS7_64_1的ip:192.168.2.101

服务器CentOS7_64_2的ip:192.168.2.102

服务器CentOS7_64_3的ip:192.168.2.103

首先我们将另外两台也按照如上方式进行配置,首先保证每台机器自己启动zookeeper成功,配置好后我们现在是拥有3台单机的zookeeper,那么下面我们进行集群的配置

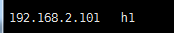

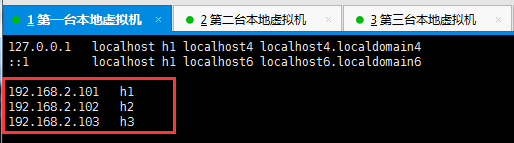

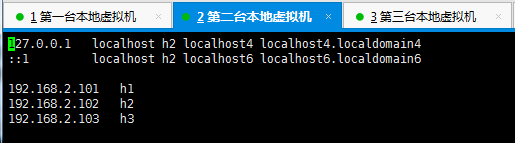

hosts配置

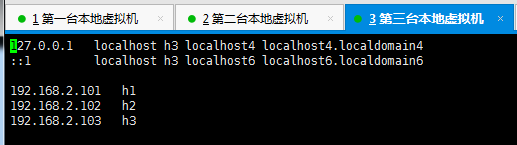

首先修改3台虚拟机的hosts映射配置:vi /etc/hosts,3台机器分别加上自己ip和hosts别名的映射(修改后自动生效),如下:

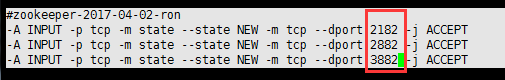

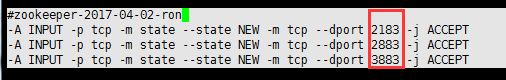

修改防火墙端口

接下来配置3台服务器的端口,防火墙那一块改为下面对应的端口

机器1—端口:2181,2881,3881

机器2—端口:2182,2882,3882

机器3—端口:2183,2883,3883

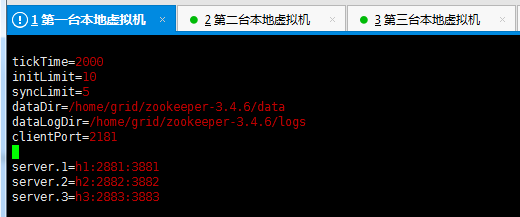

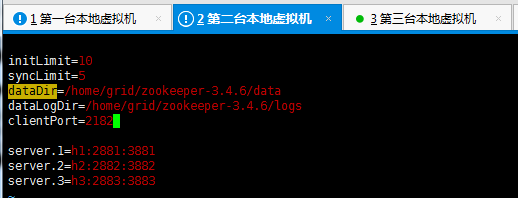

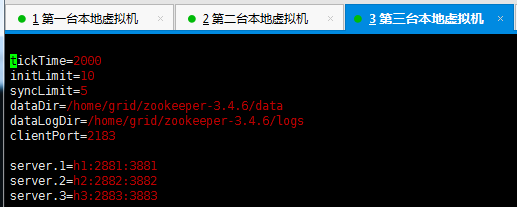

zookeeper配置

注意3台机器**端口号**参数

vi /conf/zoo.cfg

另修改data文件夹下的myid文件的值,分别对应的值为1,2,3

启动zookeeper

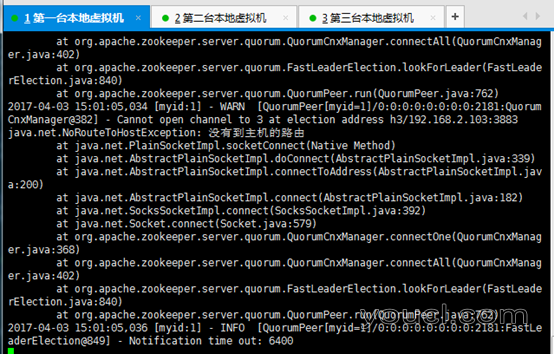

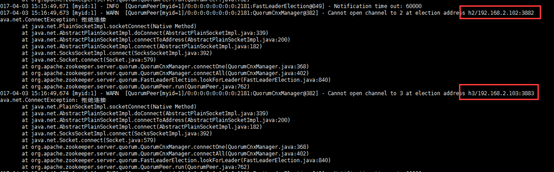

我启动了第一台服务出了如下异常,于是我想应该是防火墙的哪个配置未生效

异常信息:

Cannot open channel to 2 at election address h2/192.168.2.102:3882

java.net.NoRouteToHostException: 没有到主机的路由

应该是防火墙配置改了未生效,于是重新启动了3台机器防火墙

service iptables restart

下面是我重新启动后抛出的异常

异常信息:

Cannot open channel to 1 at election address h1/192.168.2.101:3881

java.net.ConnectException: 拒绝连接

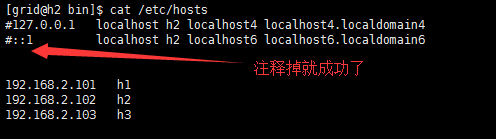

解决异常

一开始认为是等待其他机器开启,但启动其他两台后一直出现该问题,所以花了半个小时查原因,后来检查没发现配置问题,但3台机器的hosts文件中有如下内容,决定尝试注释后重启,正常启动

127.0.0.1 localhost h1 localhost4 localhost4.localdomain4

::1 localhost h1 localhost6 localhost6.localdomain6

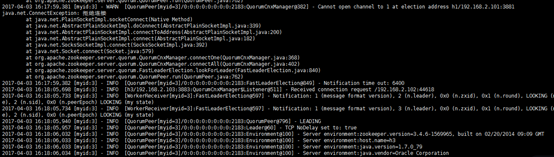

再次重启成功

下图这里开始启动出错的原因是集群环境正等待着另外几台机器,否则一台也没办法进行选举等操作,第二台机器起来后就恢复正常了。

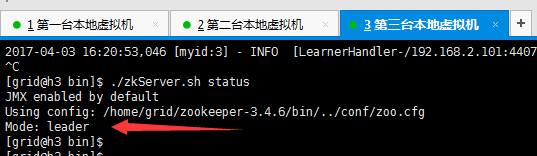

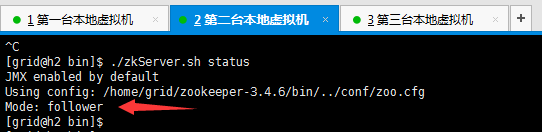

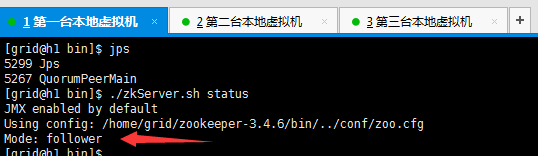

查看状态

接下来我们运行status命令分别查看各自的状态

启动的第一台机器:3号机-领导者

启动的第二台机器:2号机-跟随者

启动第三台机器:1号机-跟随者

一旦leader停止服务,剩下的follower会选举出leader,大家可以尝试下看看状态变化