Apache的Hadoop是一个开源框架构建跨计算机集群分布的大数据存储和处理数据。 该项目基于以下组件:

- Hadoop的通用 -它含有其他Hadoop的模块所需的Java库和实用程序。

- HDFS - Hadoop分布式文件系统-跨多个节点分发的基于Java的可扩展文件系统。

- MapReduce的 -并行大数据处理YARN框架。

- Hadoop的纱线 :一个群集资源管理框架。

在CentOS 7中安装Hadoop

本文将指导你如何在CentOS 7单节点集群上安装的Apache Hadoop的(同样适用于RHEL 7和Fedora 23+版本)。 这种类型的配置也引用为Hadoop的伪分布式模式 。

第1步:在CentOS 7上安装Java

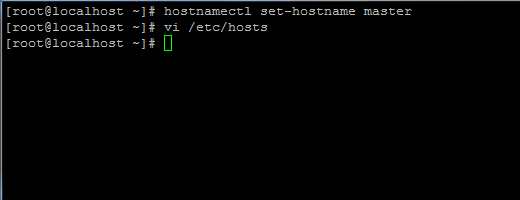

1.在使用Java安装,用root用户第一次登录或具有root权限的设置你的机器的主机名使用以下命令用户进行。

# hostnamectl set-hostname master

在CentOS 7中设置主机名

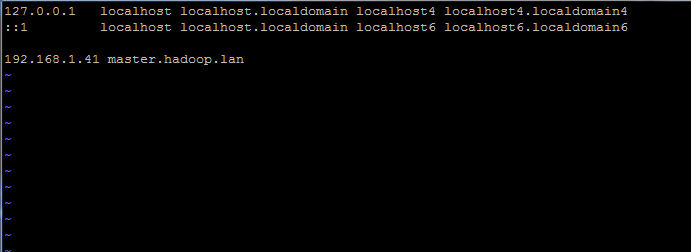

此外,在hosts文件中添加一个新记录,使用您自己的计算机FQDN指向您的系统IP地址。

# vi /etc/hosts

添加以下行:

192.168.1.41 master.hadoop.lan

在/ etc / hosts文件中设置主机名

使用您自己的设置替换上述主机名和FQDN记录。

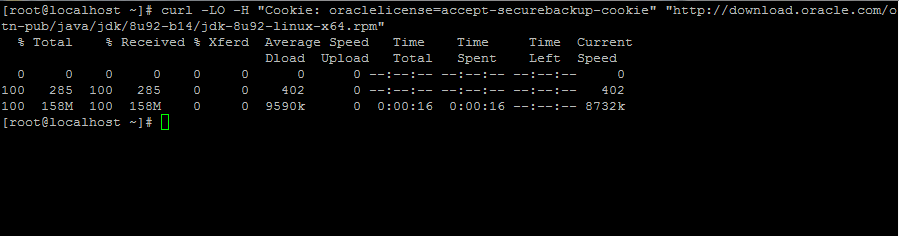

2.接下来,进入甲骨文的Java下载页面,下载最新版本的Java SE开发工具包8系统使用curl命令的帮助上:

# curl -LO -H "Cookie: oraclelicense=accept-securebackup-cookie" “http://download.oracle.com/otn-pub/java/jdk/8u92-b14/jdk-8u92-linux-x64.rpm”

下载Java SE开发包8

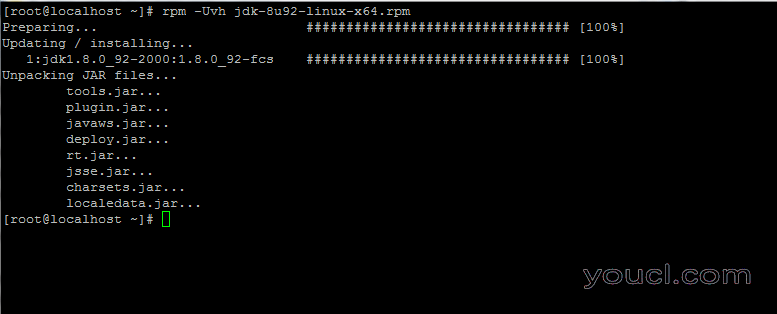

3. Java二进制文件下载完成后,通过发出以下命令来安装软件包:

# rpm -Uvh jdk-8u92-linux-x64.rpm

在CentOS 7中安装Java

第2步:在CentOS 7中安装Hadoop Framework

4.接下来,在系统上创建一个新的用户帐户没有root权限,我们将用它来Hadoop的安装路径和工作环境。 新帐户的主目录将驻留在/opt/hadoop目录。

# useradd -d /opt/hadoop hadoop # passwd hadoop

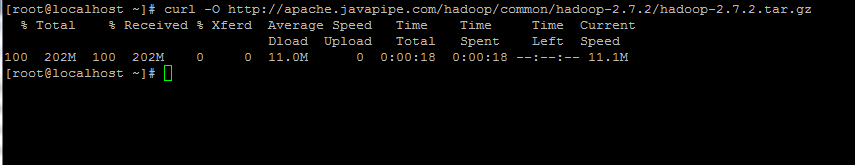

5.在接下来参观的Apache Hadoop的页面,以获得链接,最新的稳定版本和下载你的系统上的归档。

# curl -O http://apache.javapipe.com/hadoop/common/hadoop-2.7.2/hadoop-2.7.2.tar.gz

下载Hadoop Package

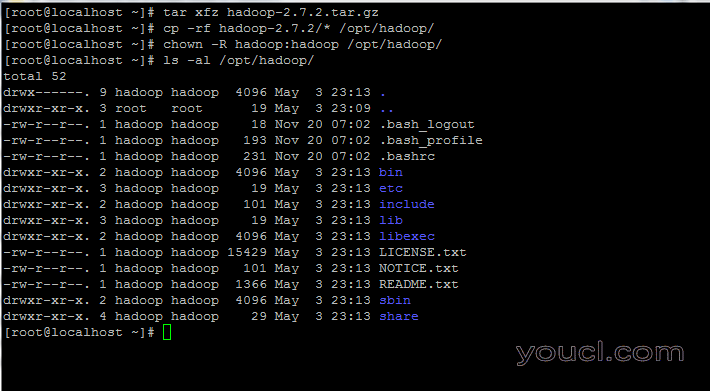

6.将归档副本的目录内容的Hadoop帐户主路径。 此外,请确保相应地更改复制的文件权限。

# tar xfz hadoop-2.7.2.tar.gz # cp -rf hadoop-2.7.2/* /opt/hadoop/ # chown -R hadoop:hadoop /opt/hadoop/

提取和设置Hadoop的权限

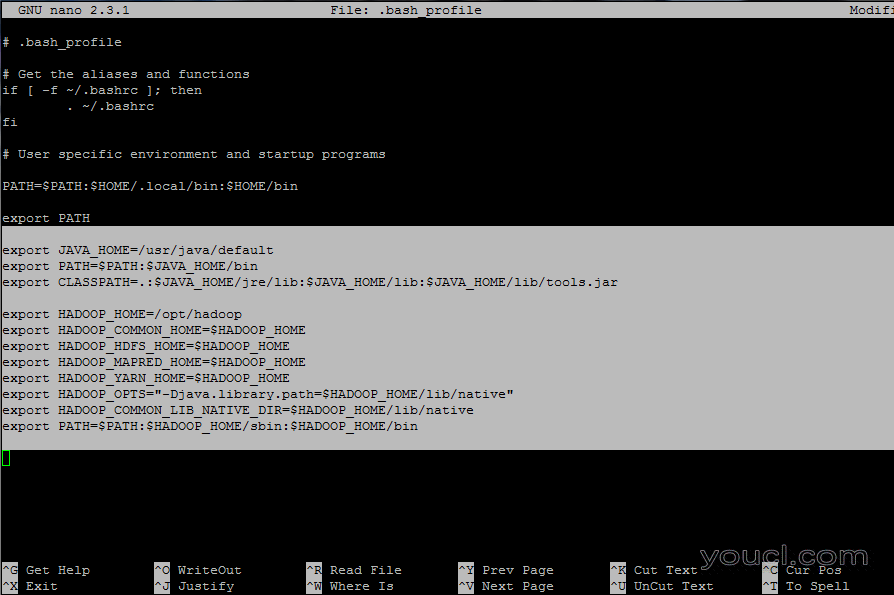

7.接下来,登录用Hadoop用户通过编辑配置系统在Hadoop和Java环境变量 .bash_profile文件。

# su - hadoop $ vi .bash_profile

在文件末尾追加以下行:

## JAVA env variables export JAVA_HOME=/usr/java/default export PATH=$PATH:$JAVA_HOME/bin export CLASSPATH=.:$JAVA_HOME/jre/lib:$JAVA_HOME/lib:$JAVA_HOME/lib/tools.jar ## HADOOP env variables export HADOOP_HOME=/opt/hadoop export HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOME export HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_YARN_HOME=$HADOOP_HOME export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib/native" export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin

配置Hadoop和Java环境变量

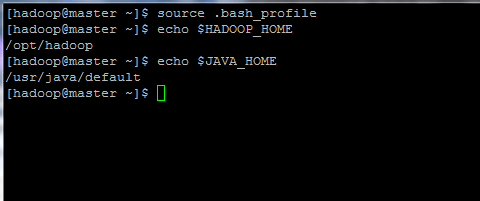

8.现在,初始化环境变量并发出以下命令检查其状态:

$ source .bash_profile $ echo $HADOOP_HOME $ echo $JAVA_HOME

初始化Linux环境变量

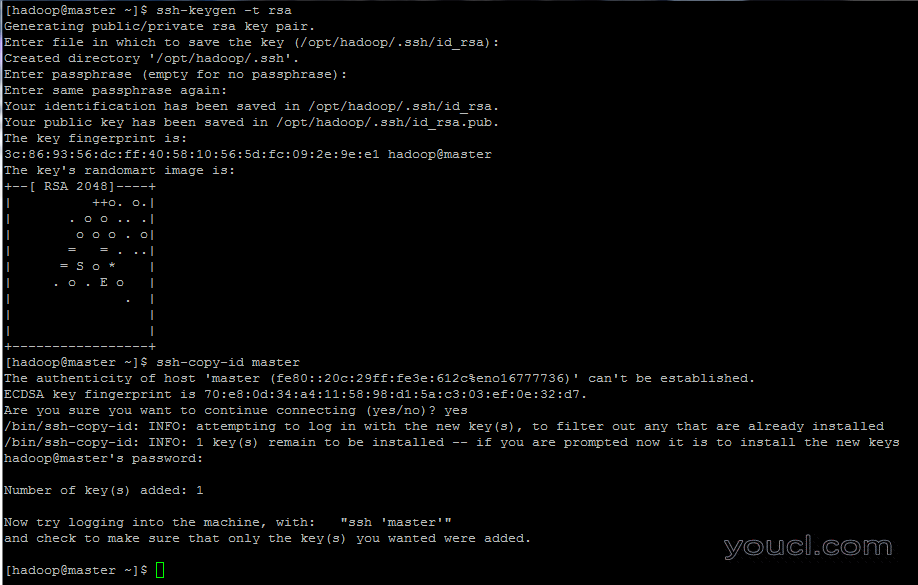

9.最后,通过运行下面的命令配置Hadoop的帐户基于SSH密钥的身份验证(更换对主机名或FQDN ssh-copy-id相应命令)。

此外,休假,以便通过SSH自动登录备案空白密码 。

$ ssh-keygen -t rsa $ ssh-copy-id master.hadoop.lan

配置基于SSH密钥的认证